陶哲轩携AI再战数学!o4-mini秒怂弃赛,Claude 20分钟通关

陶哲轩携AI再战数学!o4-mini秒怂弃赛,Claude 20分钟通关陶哲轩YouTube视频第二弹震撼来袭!这一次,他让AI挑战在Lean中形式化代数蕴含证明,结果Claude约20分通关,o4-mini太过谨慎直接「弃赛」。

陶哲轩YouTube视频第二弹震撼来袭!这一次,他让AI挑战在Lean中形式化代数蕴含证明,结果Claude约20分通关,o4-mini太过谨慎直接「弃赛」。

从国际顶流 GPT-4 128K、Claude 200K 到国内「当红炸子鸡」支持 200 万字上下文的 Kimi Chat,大语言模型(LLM)在长上下文技术上不约而同地卷起来了

就在刚刚,Anthropic发现了大模型的惊人漏洞。经过256轮对话后,Claude 2逐渐被「灌醉」,开始疯狂越狱,帮人类造出炸弹!谁能想到,它的超长上下文,反而成了软肋。

大模型厂商在上下文长度上卷的不可开交之际,一项最新研究泼来了一盆冷水——Claude背后厂商Anthropic发现,随着窗口长度的不断增加,大模型的“越狱”现象开始死灰复燃。无论是闭源的GPT-4和Claude 2,还是开源的Llama2和Mistral,都未能幸免。

AI训AI必将成为一大趋势。Meta和NYU团队提出让大模型「自我奖励」的方法,让Llama2一举击败GPT-4 0613、Claude 2、Gemini Pro领先模型。

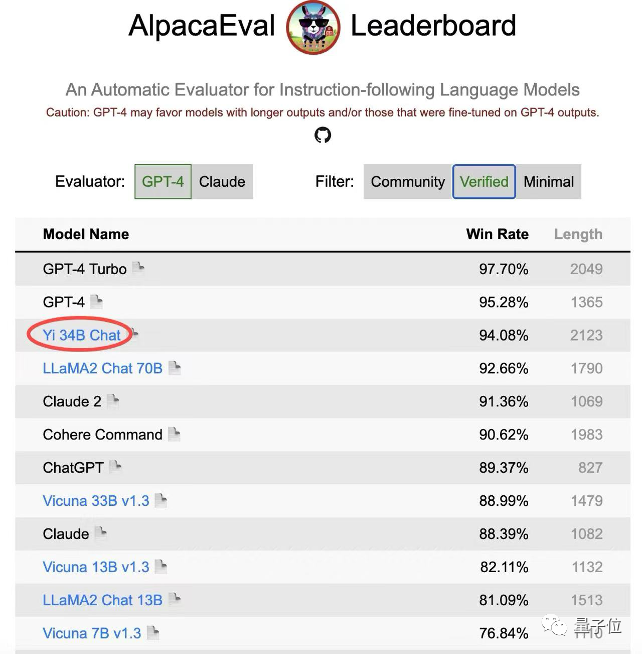

仅次于GPT-4,李开复零一万物Yi-34B-Chat最新成绩公布——在Alpaca经认证的模型类别中,以94.08%的胜率,超越LLaMA2 Chat 70B、Claude 2、ChatGPT!

让大模型洗钱、制造炸弹、合成冰毒?GPT-4、 Claude 2纷纷沦陷了。让大模型成功越狱,还是有机可乘。

月初刚测了GPT-4 Turbo上下文真实实力的大神Greg Kamradt又盯上了Anthropic刚更新的Claude 2.1。他自己花了1016刀测完之后显示,Claude 2.1在上下文长度达到90K后,性能就会出现明显下降。

OpenAI开发者大会后不久,它的最强竞对Claude也宣布推出了重磅更新。更新后的Claude 2.1,上下文长度直接翻番到20万,重新超过了GPT-4。

悄无声息,羊驼家族“最强版”来了! 与GPT-4持平,上下文长度达3.2万token的LLaMA 2 Long,正式登场。